Tag: SEO

Mitte der 1990er Jahre fingen die ersten Suchmaschinen im WWW an, das frühe Web zu erfassen. Die Seitenbesitzer erkannten zügig den Wert einer lieblings Positionierung in den Resultaten und recht bald entwickelten sich Betriebe, die sich auf die Verfeinerung ausgerichteten.

In Anfängen ereignete sich der Antritt oft bezüglich der Transfer der URL der speziellen Seite in puncto verschiedenen Suchmaschinen im WWW. Diese sendeten dann einen Webcrawler zur Auswertung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Website auf den Web Server der Suchmaschine, wo ein 2. Programm, der gern genutzte Indexer, Angaben herauslas und katalogisierte (genannte Ansprüche, Links zu anderweitigen Seiten).

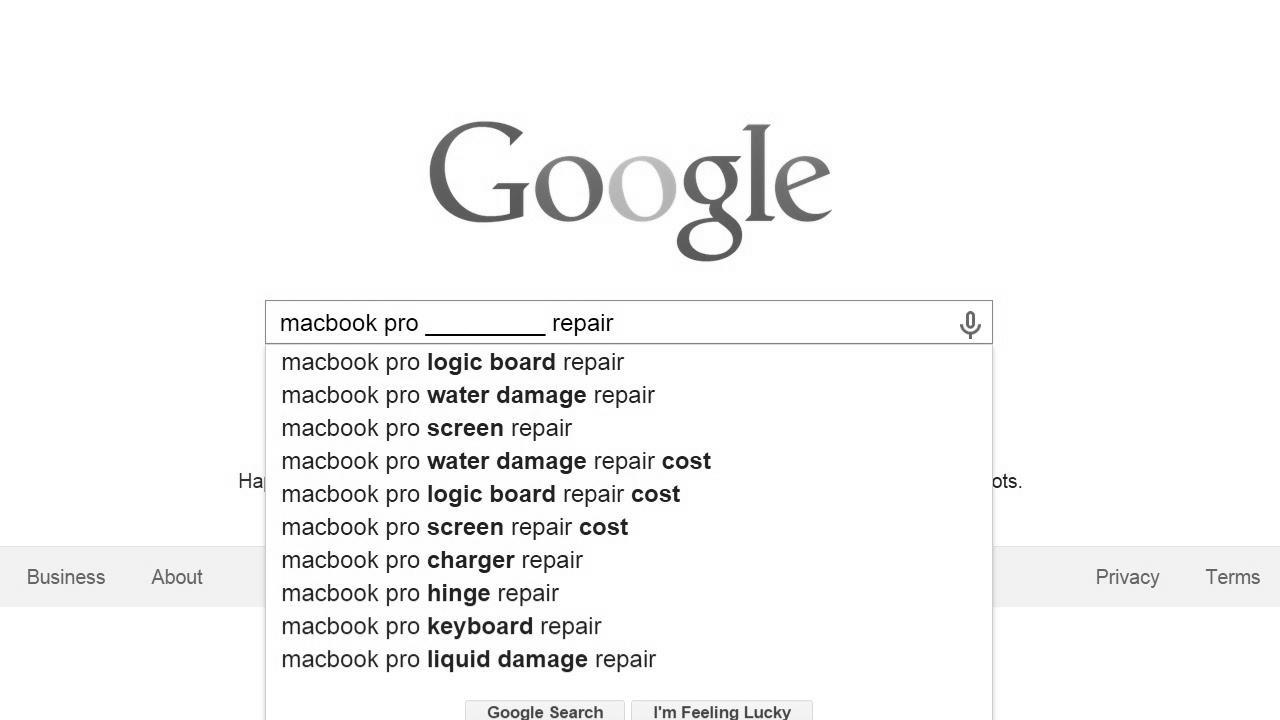

Die zeitigen Modellen der Suchalgorithmen basierten auf Angaben, die aufgrund der Webmaster sogar existieren wurden von empirica, wie Meta-Elemente, oder durch Indexdateien in Search Engines wie ALIWEB. Meta-Elemente geben eine Übersicht per Gehalt einer Seite, aber stellte sich bald herab, dass die Benutzung er Vorschläge nicht solide war, da die Wahl der genutzten Schlagworte dank dem Webmaster eine ungenaue Abbildung des Seiteninhalts spiegeln kann. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Kanten bei speziellen Recherchieren listen.[2] Auch versuchten Seitenersteller diverse Punkte innert des HTML-Codes einer Seite so zu manipulieren, dass die Seite stärker in den Resultaten aufgeführt wird.[3]

Da die zeitigen Search Engines sehr auf Gesichtspunkte abhängig waren, die allein in den Händen der Webmaster lagen, waren sie auch sehr vulnerabel für Schindluder und Manipulationen im Ranking. Um höhere und relevantere Resultate in Ergebnissen zu bekommen, mussten wir sich die Unternhemer der Search Engines an diese Umständen angleichen. Weil der Gewinn einer Suchmaschine davon zusammenhängt, besondere Suchergebnisse zu den gestellten Suchbegriffen anzuzeigen, vermochten untaugliche Testurteile dazu führen, dass sich die Mensch nach diversen Optionen zur Suche im Web umblicken. Die Lösung der Suchmaschinen im WWW lagerbestand in komplexeren Algorithmen für das Rang, die Kriterien beinhalteten, die von Webmastern nicht oder nur mühevoll manipulierbar waren. Larry Page und Sergey Brin gestalteten mit „Backrub“ – dem Stammvater von Yahoo – eine Search Engine, die auf einem mathematischen KI basierte, der anhand der Verlinkungsstruktur Kanten gewichtete und dies in Rankingalgorithmus reingehen ließ. Auch alternative Suchmaschinen im WWW bezogen pro Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein.

Mitteilung: How To Create A Compelling Brand – Module 7 – Half 2 – search engine optimisation Unlocked

Meldung: search engine marketing أربع خطوات بسيطة للترتيب رقم 1 على جوجل – سيو : تحسين محركات البيبئئد

Mitteilung: How To Create Content material That Boosts Thought Management & web optimization

How To: find out how to earn cash from website positioning fast – how to become profitable with search engine optimisation – simple begin – generate profits first

Create search engine optimization Content material With DemandJump – 30 Seconds – Model B

Mehr zu: How To Create A Keyword Record For search engine optimisation

Content Writing Full Course | The best way to turn out to be a Content material Writer? – search engine marketing writing tutorial

Mitteilung: Making a super web optimization directory web site, utilizing WordPress

How To: What To Charge For Local search engine optimisation  (How Much Should Clients Pay You?)

(How Much Should Clients Pay You?)